Auch wenn es wenig überraschend war, als die Uni Hannover alle im Februar 2021 stattfindenden Präsenzklausuren abgesagt hat und die Durchführung von elektronischen Klausuren empfohlen hat, mussten schnell sinnvolle Lösungen gefunden werden. Von einer Form der elektronischen Klausur, die mein Chef Daniel Lohmann "Fernklausuren" getauft hat und die wir gemeinsam am SRA ausgearbeitet haben, will ich in diesem kurzen Artikel erzählen.

Vorneweg will ich aber sagen, dass jede Form der elektronischen Klausur, bei denen wir Prüfer*innen die Umgebung der Prüflinge nicht kontrollieren können, schlecht ist. Es ist prinzipbedingt, durch den Zugang der Studierenden zum Internet und zu Kommunikationsmöglichkeiten, unmöglich kontrollierte Bedingungen zu schaffen, bei denen Unterschleif im gleichen Maße verhindert (oder zumindest erkannt) werden kann wie bei einer Präsenzklausur. Andere Formen von Prüfungen, wie Hausarbeiten oder mündliche Prüfungen, sind zwar in dieser Hinsicht leichter ins Elektronische übertragbar, haben aber den Nachteil nicht zu skalieren. Daher will ich mich hier nur mit der Klausur als Prüfungsform auseinandersetzten und unser Vorgehen beschreiben, wie wir versucht haben möglichst viele der guten Eigenschaften von Präsenzklausuren in "Fernklausuren" umzusetzen. Unsere Zielsetzungen bei der Konzeptionierung waren dabei folgende Punkte:

- Geringe technische Anforderungen, welche die Student*innen erfüllen müssen.

- Minimierung der Unterschleifmöglichkeiten.

- Fehlertolerant gegenüber technischen Störungen während der Klausur.

- Eine Prüfungsform, die den Studierenden bereits bekannt und die in dieser turbulenten Zeit einige gewisse Vertrautheit bietet.

Das Vorgehen

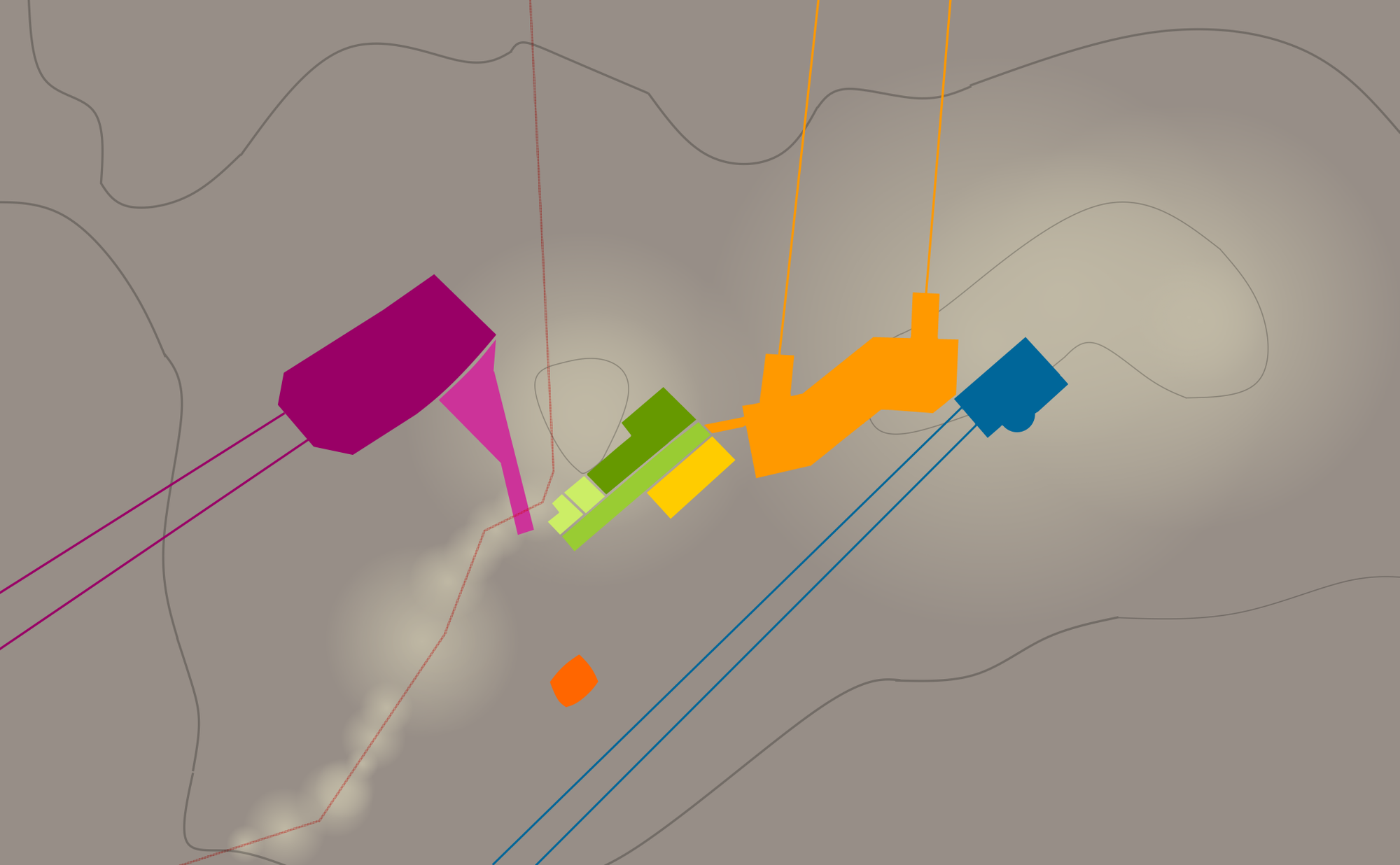

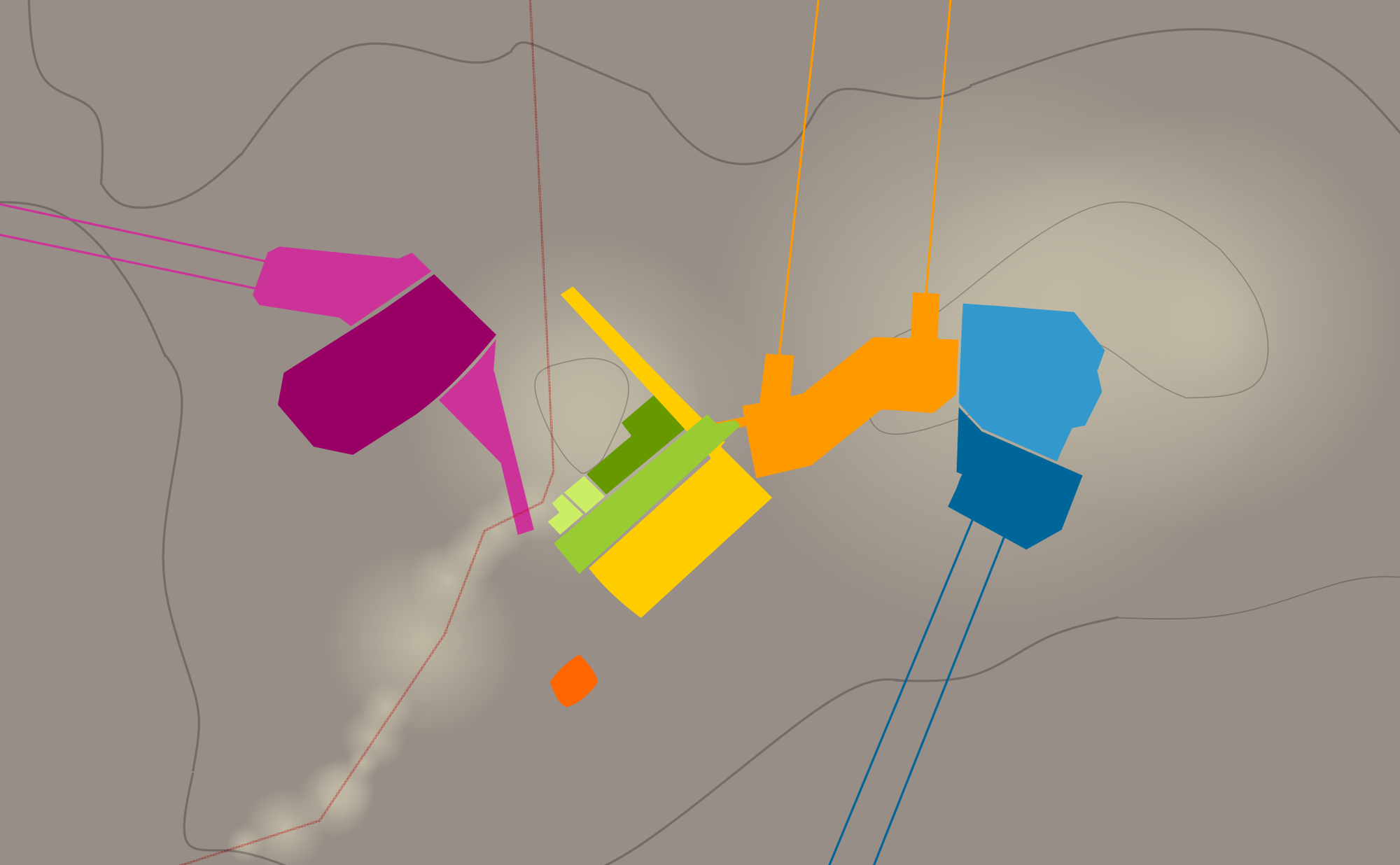

Der erste Schritt bei der Durchführung einer Fernklausur ist es eine schriftliche Klausurvorlage zu erstellen, die randomisierbar ist. Dabei muss man darauf achten, dass zum einen jede abgeleitete Klausur den gleichen Schwierigkeitsgrad hat und die Antworten auf die Fragen nicht trivial im Internet auffindbar sind. Aus dieser randomisierbaren Klausur erstellen wir für Jeden eine ganz individuelle Klausur samt zugehöriger Musterlösung. Auf diese Weise führt ein Austausch zwischen den Student*innen nur zu Chaos und Verwirrung.

Als zweites Verschlüsseln wir alle individuellen Klausuren (PDF-Dateien) mit dem gleichen Passwort und lassen verschicken die Dateien bereits im Vorfeld der eigentlichen Prüfung (24 Stunden vorher) an alle Angemeldeten. Auf diese Weise können sich alle die nötigen Dateien bereits im Vorfeld herunterladen und im Zweifel die Klausur auch in einer Hütte im Wald schreiben (was bei beengten Wohnverhältnissen durchaus eine praktikable Option auf einen ruhigen Ort sein kann). Zusammen mit der verschlüsselten Klausur kommt noch eine detaillierte Schritt-für-Schritt-Anleitung und ein Tool um einen SHA256-Hash einer Datei zu berechnen.

Am Tag der Klausur kommen alle Prüflinge in eine BigBlueButton-Session, in der sie 15 Minuten vor dem eigentlichen Klausurbeginn das Passwort für die Klausur erhalten. Diese Zeit ist zum Entschlüsseln und gegebenenfalls Drucken der Klausur gedacht. Da jeder Prüfling unterschiedlich lange für diesen Schritt brauchen wird, muss man dies bei der Erstellung der Klausur bedenken. Zeit darf bei dieser Form der Klausur nicht der limitierende Faktor für die Bearbeitung sein. Wenn ein Prüfling zu diesem Zeitpunkt kein Internet hat, haben wir in der Anleitung mehrere Telefonnummern angegeben, unter denen wir gegen Name und Matrikelnummer das Passwort herausgeben.

Im eigentlichen Prüfungszeitraum müssen die Studentinnen die Prüfung handschriftlich* bearbeiten. Dies hat zum einen der Vorteil, dass wir die gewohnte Form der schriftlichen Klausur haben, aber auch dass wir mehrere Seiten an handschriftliche Proben haben, wenn es zu Zweifeln bezüglich Unterschleif kommen sollte. Dabei haben wir 3 Möglichkeiten vorgesehen die Klausur zu Bearbeiten: (1) Ausfüllen am Tablet, (2) Ausfüllen auf einem Ausdruck der Klausur und (3) Bearbeitung auf Blanko-Papier. Für die letztere Methode haben wir jedes auszufüllende Feld mit einer eindeutigen Nummer versehen. Auf die Weise kann man Antwortfelder eindeutig vom Blank-Papier aus referenzieren. Daher besteht bei Fernklausuren kein Bedarf an einem Drucker.

Während der Klausur verwenden wir den BigBlueButton-Raum nur als Möglichkeit zum technischen Support und um Ansagen machen zu können. Dabei haben wir alle Studierenden zu je 50 Leute in Gruppen eingeteilt, die jeweils eigene Räume haben. Während der Klausur sind alle betreuenden Mitarbeiter im ständigen Austausch, indem sie in einer gemeinsamen Telefonkonferenz sind.

Nach dem Ende der Zeit müssen die Student*innen einen Scan der Klausur erzeugen, falls die Bearbeitung auf Papier stattgefunden hat. Dabei braucht es auch nicht unbedingt einen Scanner, ein modernes Smartphone und passende Scanner-Apps reichen völlig aus um ein Abgabe-PDF zu erzeugen. Wenn alles klappt, muss man die eigene Abgabe nur noch auf der Lernplattform der Universität hochladen und ist fertig mit der Klausur. Für diesen Schritt nach der Klausur haben wir wieder 15 Minuten eingeplant.

Wenn zum Abgabezeitpunkt das Internet stirbt oder die eigene Internetleitung nicht dick genug ist um große Scans hochzuladen, haben wir noch die Möglichkeit vorgesehen eine Prüfsumme der Abgabe zu Erstellen. Dazu haben wir beim Verschicken eine HTML-Datei mitgegeben, die in den meisten modernen Browsern läuft, und mit deren Hilfe man einen SHA256 berechnen kann. Das Abgeben der Prüfsumme kann per Chat, Mail oder (von der Hütte im Wald aus) per Telefon geschehen.

Weitere Hinweise

- Die randomisierte Klausurvorlage ist Code und muss unbedingt von mehreren Mitarbeitern begutachtet werden. Ein Fehler in der Vorlage würde zu einer Babylonischen Verwirrung führen.

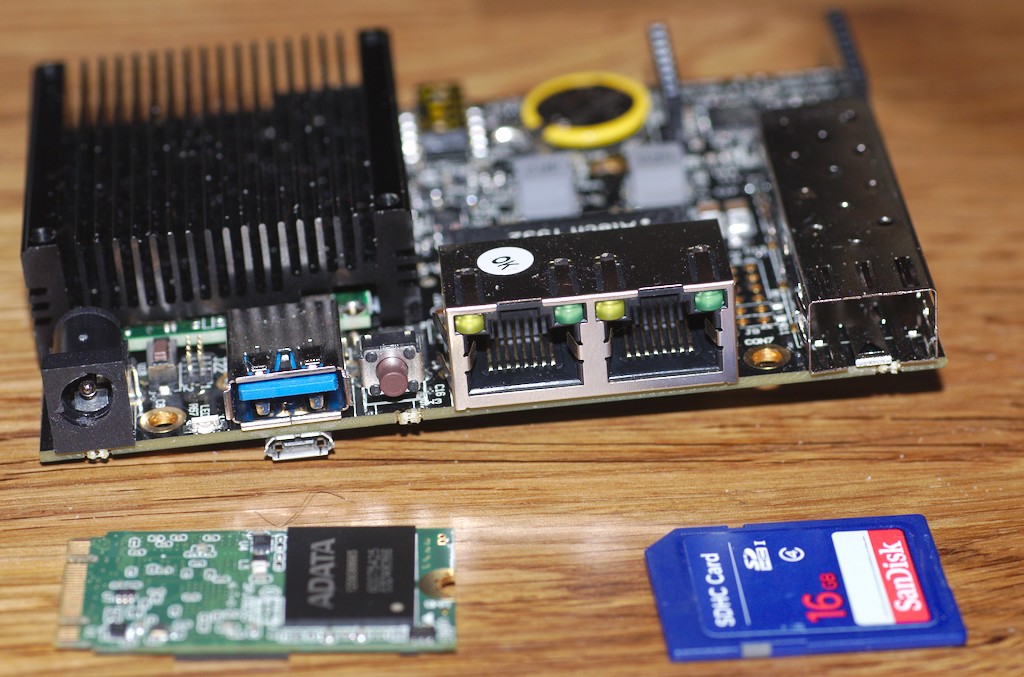

- Es ist Tooling zum Erstellen und Verschicken der Klausuren zwingend notwendig. Wir haben eine Mischung aus Jinja2-Templates, LaTeX, und der Stud.IP-API zum Klausurversand verwendet.

- Ein Probelauf mit den Prüflingen einige Tage vor der eigentlichen Klausur ist wichtig. Auf diese Weise lernen alle Beteiligte das Prozedere kennen und sind zum richtigen Termin nicht so aufgeregt.

- Manche Student*innen haben so großartige Smartphones, dass bei 10 Seiten Klausur 250MiB PDF-Dateien rausfallen. Es ist als von Vorteil eine Möglichkeit in der Hinterhand zu haben um große Dateien hochladen zu können. Dienste wie Seafile und Nextcloud bieten sich hier an.

- Die Prüfsumme als Fallback wurde tatsächlich von einigen Student*innen verwendet, wenn auch für einige nur zum Beruhigen der eigenen Unsicherheit ("Habt ihr die Datei mit dem Hash xxx erhalten?").

Es ist kein Geheimnis, dass Deutschland nach Schröder und Merkel ohne eine Volkspartei mit einer wirkliche Vision oder Ideologie da steht, während viele das gar nicht so schlecht finden mögen, ist es doch diese Ideenlosigkeit, welche auch einer der Gründe für den Aufstieg der AfD ist. Dort wo Merkel all jene, die wirklich eine konservative Politik wollten verloren hat, schöpft die AfD, abseits des braunen Sumpfes, aus dem die NPD nie herauskam und in welchen die Medien und die etablierten Parteien sie gerne einsortieren würden. Doch die alten Ideologien sind nicht nur an Schröder und Merkel gestorben, ihnen fehlt es auch heute an dem Bezug zur gesellschaftlichen Realität.

Es ist kein Geheimnis, dass Deutschland nach Schröder und Merkel ohne eine Volkspartei mit einer wirkliche Vision oder Ideologie da steht, während viele das gar nicht so schlecht finden mögen, ist es doch diese Ideenlosigkeit, welche auch einer der Gründe für den Aufstieg der AfD ist. Dort wo Merkel all jene, die wirklich eine konservative Politik wollten verloren hat, schöpft die AfD, abseits des braunen Sumpfes, aus dem die NPD nie herauskam und in welchen die Medien und die etablierten Parteien sie gerne einsortieren würden. Doch die alten Ideologien sind nicht nur an Schröder und Merkel gestorben, ihnen fehlt es auch heute an dem Bezug zur gesellschaftlichen Realität.